Clase 2: Algoritmos de Valores propios¶

Bibliografía de la Clase:

- Numerical Linear Algebra.L.N. Trefethen. Chapter 5: Lecture 25 Overview of Eigenvalue Algorithms

- Introduction to Linear Algebra. Gilbert Strang. Chapter 6 Eigenvalues and Eigenvectors

- Guía profesor Luis Salinas

Alternativa 1: Polinomio característico¶

La primera idea para el cálculo de los valores y vectores propios de una matriz

es encontrar su polinomio característico, cuyas raíces son los valores

propios, para luego proceder a encontrar sus respectivos vectores propios.

es encontrar su polinomio característico, cuyas raíces son los valores

propios, para luego proceder a encontrar sus respectivos vectores propios.

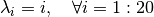

La imagen mostrada corresponde a el polinomio cuyas raíces son  . Se ve claramente que es un problema mal condicionado, debido a

que el polinomio encontrado es muy sensible a sus coeficientes.

. Se ve claramente que es un problema mal condicionado, debido a

que el polinomio encontrado es muy sensible a sus coeficientes.

Es decir, hemos transformado un problema bien condicionado, en uno mal condicionado.

Problema

La búsqueda de raíces en un polinomio, es un problema mal condicionado

(ver Clase Condicionamiento CC1). Por otro lado, se sabe del

Algebra que no existe una fórmula para determinar los ceros de un

polinomio arbitrario de grado  a partir de sus coeficientes.

a partir de sus coeficientes.

Lo anterior muestra que no es posible expresar las raíces de un polinomio como una expresión algebraica y por lo tanto la única forma de obtenerlos es de forma iterativa (con un número infinito de pasos).

Nota

La fórmula para resolver ecuaciones de segundo grado ya era conocida

por los antiguos babilonios. Fibonacci a principios del siglo XIII encontró solución a la ecuación de tercer grado

y Scipione del Ferro, Niccolò Tartaglia y

Gerolamo Cardano generalizaron la formulación. Ludovico Ferrari,

discípulo de Cardano en el siglo XVI expresó la solución para

ecuaciones de cuarto grado.

y Scipione del Ferro, Niccolò Tartaglia y

Gerolamo Cardano generalizaron la formulación. Ludovico Ferrari,

discípulo de Cardano en el siglo XVI expresó la solución para

ecuaciones de cuarto grado.

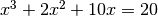

Alternativa 2: Método de Iteración de Potencia¶

Este método consiste en construir una secuencia que converge al vector propio

que corresponde al mayor valor propio en valor absoluto

que corresponde al mayor valor propio en valor absoluto  . La secuencia es la siguiente:

. La secuencia es la siguiente:

¿Porqué funciona?

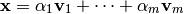

Si escribimos  como una combinación lineal de los vectores propios

se tiene:

como una combinación lineal de los vectores propios

se tiene:

Al multiplicar sucesivamente por  se tiene que el vector propio

se tiene que el vector propio  es el que predomina la sucesión y por lo

tanto la sucesión converge a él:

es el que predomina la sucesión y por lo

tanto la sucesión converge a él:

Problemas

El método es muy lento y presenta problemas cuando hay más de un valor

propio con módulo máximo (ej: números complejos  ). Hay

problemas también si se elige un vector de partida

). Hay

problemas también si se elige un vector de partida  que no sea combinación lineal del vector

que no sea combinación lineal del vector  .

.

Otras Alternativas¶

Los mejores algoritmos para valores propios están basados en un principio distinto: calcular factorizaciones de A que revelen sus factores propios.

Una de las factorizaciones que revelan valores propios (ver Clase 1 ) es llamada la Descomposición de Schur, que existe para toda matriz y permite encontrar una triangularización unitaria.

La estrategia para construir estas factorizaciones consiste en aplicar una

secuencia de transformaciones a  para introducir ceros donde se requiera.

para introducir ceros donde se requiera.

Descomposición de Schur¶

La descomposición de Schur de una matriz  tiene la siguiente

definición:

tiene la siguiente

definición:

Factorización de Schur

donde

donde  es unitaria y

es unitaria y  es una matriz triangular

superior.

es una matriz triangular

superior.

Teorema¶

Toda matriz  tiene una descomposición de Schur, incluso las matrices

deficientes.

tiene una descomposición de Schur, incluso las matrices

deficientes.

Demostración¶

Digamos que  es un vector propio cualquiera de la matriz

es un vector propio cualquiera de la matriz  con

con

como su correspondiente valor propio. Definir la matriz

unitaria

como su correspondiente valor propio. Definir la matriz

unitaria  tenga como primera columna el vector

tenga como primera columna el vector

.

.

![\mathbf{U} = \left[ \begin{array}{c|c|c|c}

\, & \, & \, & \, \\

\, & \, & \, & \, \\

x & u_2 & \cdots & u_m \\

\, & \, & \, & \, \\

\, & \, & \, & \,

\end{array} \right]](_images/math/e46895bff5dfd2556a13848d15283caee014366b.png)

Si ahora construimos  se tiene:

se tiene:

![\mathbf{U}^* \mathbf{A} \mathbf{U} =

\left[ \begin{array}{ccc}

\, & \mathbf{x}^* & \, \\

\hline

\, & \mathbf{u}_2^* & \, \\

\hline

\, & \vdots & \, \\

\hline

\, & \mathbf{u}_m^* & \,

\end{array} \right]

\left[ \begin{array}{c|c|c}

\, & \, & \, \\

\, & \, & \, \\

a_1 & \cdots & a_m \\

\, & \, & \, \\

\, & \, & \,

\end{array} \right]

\left[ \begin{array}{c|c|c|c}

\, & \, & \, & \, \\

\, & \, & \, & \, \\

x & u_2 & \cdots & u_m \\

\, & \, & \, & \, \\

\, & \, & \, & \,

\end{array} \right]](_images/math/a6fd88f4b00c12bd86e2ebd5c989df988fb9befd.png)

Al multiplicar se tiene:

![\mathbf{U}^* \mathbf{A} \mathbf{U} =

\left[ \begin{array}{c|ccc}

\lambda & x^*.A.u_2 & \dots & x^*.A.u_m \\

\hline

0 & u_2^*.A.u_2 & \dots & u_2^*.A.u_m \\

\vdots & \vdots & & \vdots \\

0 & u_m^*.A.u_2 & \dots & u_m^*.A.u_m

\end{array} \right] =

\left[

\begin{array}{c|c}

\lambda & \mathbf{B} \\

\hline

\mathbf{0} & \mathbf{C}

\end{array} \right]](_images/math/cc4abb3ad47e120b10c1299e1e95659b9f5f8b90.png)

Por hipótesis inductiva, la matriz  también tiene descomposición de

Schur, por lo tanto:

también tiene descomposición de

Schur, por lo tanto:

Entonces, como:

![\mathbf{U}^* \mathbf{A} \mathbf{U} =& \left[

\begin{array}{c|c}

\lambda & \mathbf{B} \\

\hline

\mathbf{0} & \mathbf{C}

\end{array} \right] \\

=& \left[

\begin{array}{c|c}

\lambda & \mathbf{B} \\

\hline

\mathbf{0} & \mathbf{V} \mathbf{T} \mathbf{V}^*

\end{array} \right]

=& \left[ \begin{array}{c|c}

1 & \mathbf{0} \\

\hline

\mathbf{0} & \mathbf{V}

\end{array} \right]

\left[ \begin{array}{c|c}

\lambda & \mathbf{BV} \\

\hline

\mathbf{0} & \mathbf{T}

\end{array} \right]

\left[ \begin{array}{c|c}

1 & \mathbf{0} \\

\hline

\mathbf{0} & \mathbf{V}^*

\end{array} \right] \\](_images/math/46f07be38ffb7e05f395d5976ae13654d724fe55.png)

equivalentemente se tiene que:

![\left[ \begin{array}{c|c}

1 & \mathbf{0} \\

\hline

\mathbf{0} & \mathbf{V}^*

\end{array} \right]

\mathbf{U}^* \mathbf{A} \mathbf{U}

\left[ \begin{array}{c|c}

1 & \mathbf{0} \\

\hline

\mathbf{0} & \mathbf{V}

\end{array} \right]

=\left[ \begin{array}{c|c}

\lambda & \mathbf{BV} \\

\hline

\mathbf{0} & \mathbf{T}

\end{array} \right]](_images/math/6840cf2e0dda895841401235916b9e5e01550acd.png)

Ahora sólo basta definir  como:

como:

![\mathbf{Q}=\mathbf{U}

\left[ \begin{array}{c|c}

1 & \mathbf{0} \\

\hline

\mathbf{0} & \mathbf{V}

\end{array} \right]](_images/math/9ee7536de2c73d735134d5029136d5118ca7f2b5.png)

Finalmente se tiene que:

![\mathbf{Q}^* \mathbf{A} \mathbf{Q} = \left[ \begin{array}{c|c}

\lambda & \mathbf{BV} \\

\hline

\mathbf{0} & \mathbf{T}

\end{array} \right]](_images/math/76a72c6d75a8142df20e92ca18a77b6e9b7569de.png)

que es de forma triangular superior.

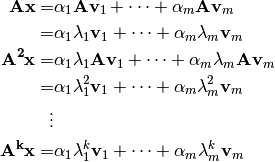

De manera más general la descomposición de Schur se obtiene transformando

con una secuencia de transformaciones del tipo

con una secuencia de transformaciones del tipo

de manera que el producto

de manera que el producto

converge a una matriz triangular superior  cuando

cuando  .

.

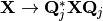

Dos fases para la factorización de Schur¶

El procedimiento anterior se realiza generalmente en dos fases:

1. Primero se produce una matriz de Hessenberg

que contiene ceros debajo de la primera subdiagonal.

2. Luego se realiza una iteración infinita de matrices de Hessenber para converger a una matriz triangular superior.

![\mathop{\left[ \begin{array}{ccccc}

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\end{array} \right]}_{\mathbf{A}}

\mathop{\xrightarrow{\hspace*{1cm}}}^{Fase 1}

\mathop{\left[ \begin{array}{c c c c c}

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\, & \times & \times & \times & \times \\

\, & \, & \times & \times & \times \\

\, & \, & \, & \times & \times \\

\end{array} \right]}_{\mathbf{H}}

\mathop{\xrightarrow{\hspace*{1cm}}}^{Fase 2}

\mathop{\left[ \begin{array}{c c c c c}

\times & \times & \times & \times & \times \\

\, & \times & \times & \times & \times \\

\, & \, & \times & \times & \times \\

\, & \, & \, & \times & \times \\

\, & \, & \, & \, & \times \\

\end{array} \right]}_{\mathbf{T}}](_images/math/a27f13bdc899be49ae35786332f8f3137d2add62.png)

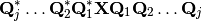

Si a es hermitiana, la matriz de Hessenberg resulta tridiagonal y el resultado final es una matriz diagonal que contiene los valores propios:

![\mathop{\left[ \begin{array}{ccccc}

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\times & \times & \times & \times & \times \\

\end{array} \right]}_{\mathbf{A}=\mathbf{A}^*}

\mathop{\xrightarrow{\hspace*{1cm}}}^{Fase 1}

\mathop{\left[ \begin{array}{c c c c c}

\times & \times & \, & \, & \, \\

\times & \times & \times & \, & \, \\

\, & \times & \times & \times & \, \\

\, & \, & \times & \times & \times \\

\, & \, & \, & \times & \times \\

\end{array} \right]}_{\mathbf{H}}

\mathop{\xrightarrow{\hspace*{1cm}}}^{Fase 2}

\mathop{\left[ \begin{array}{c c c c c}

\times & \, & \, & \, & \, \\

\, & \times & \, & \, & \, \\

\, & \, & \times & \, & \, \\

\, & \, & \, & \times & \, \\

\, & \, & \, & \, & \times \\

\end{array} \right]}_{\mathbf{T}}](_images/math/36d42cbe79bb906807da978b51511c2393150ba8.png)